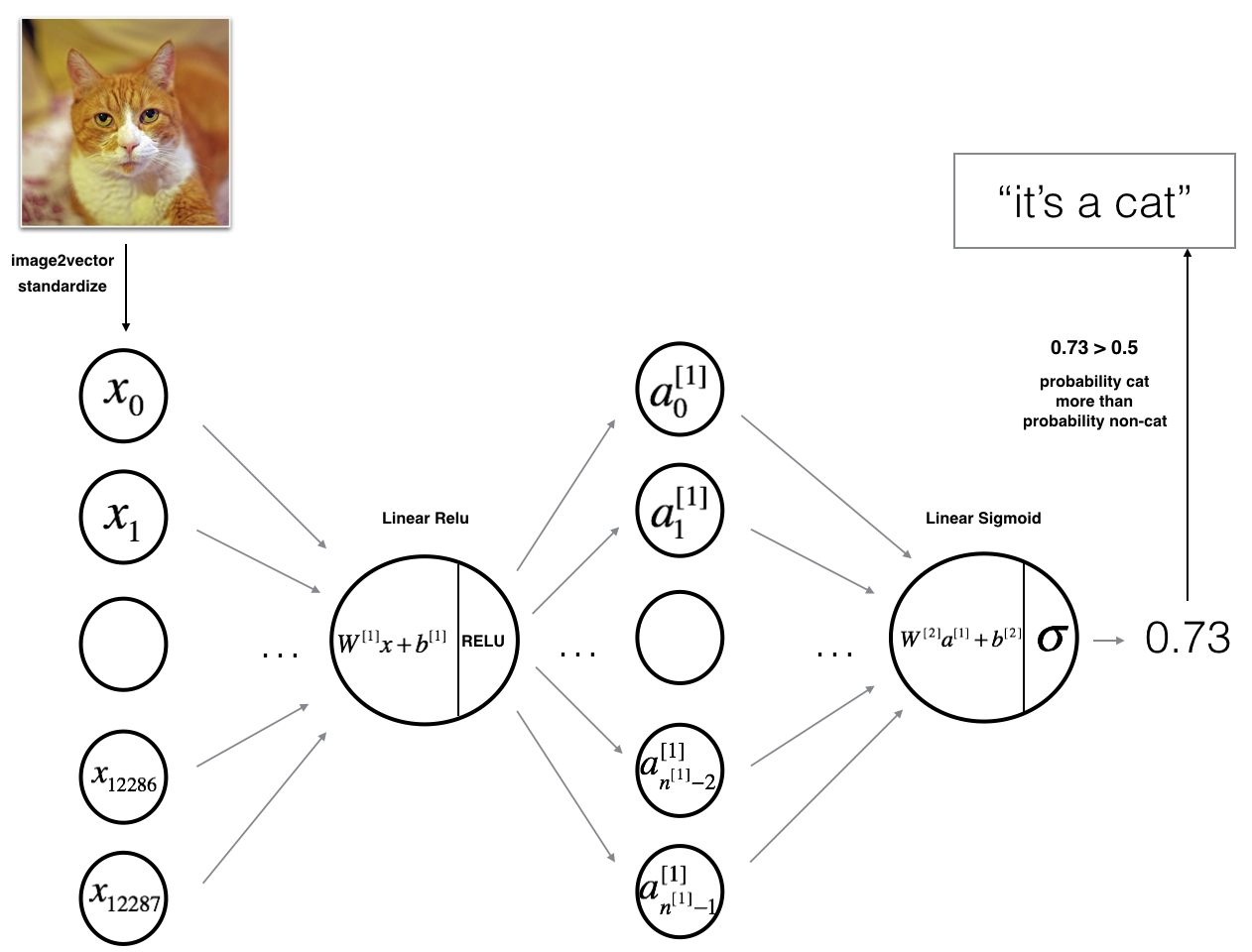

1-2层神经网络

该模型可以概括为: INPUT -> LINEAR -> RELU -> LINEAR -> SIGMOID -> OUTPUT.

- 输入是 (64,64,3) 图像,将其展平为大小为 (12288,1) 的向量。

- 相应的向量: 然后乘以大小为 的权重矩阵 。

- 然后,您添加一个偏差项并获取其偏倚以获得以下向量: .

-

然后重复相同的过程。

-

您将所得向量乘以 ,然后加上截距(偏差)。

-

最后,取最后一个激活函数为Sigmoid函数,如果大于0.5,则将其分类为猫。

-

步骤:

1 | def initialize_parameters(n_x, n_h, n_y): |

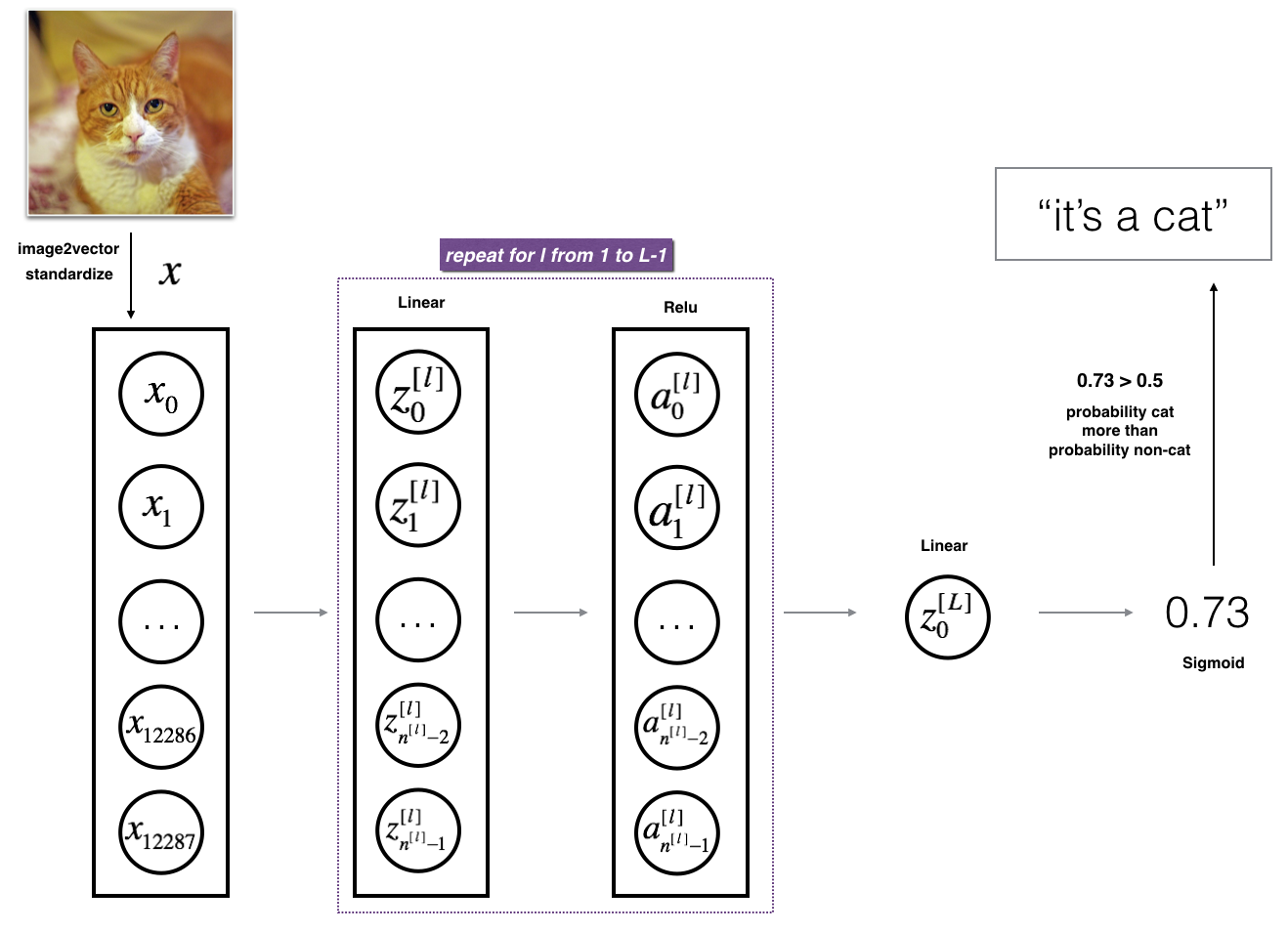

L层深度神经网络

该模型可以概括为:[LINEAR -> RELU] (L-1) -> LINEAR -> SIGMOID

-

输入是 (64,64,3) 图像,将其展平为大小为 (12288,1) 的向量。

-

相应的向量: 然后乘以权重矩阵,然后添加截距,结果称为线性单位。

-

接下来,取激活函数的ReLU,根据模型体系结构的不同,这个过程可以对每个重复多次。

-

最后,取最后一个激活函数为Sigmoid函数。如果它大于0.5,你就把它归为猫。

步骤:

1 | def initialize_parameters_deep(layers_dims): |